vSANの性能について

最近のサーバー周りではHCI(ハイパーコンバージドインフラストラクチャ)が流行っています。

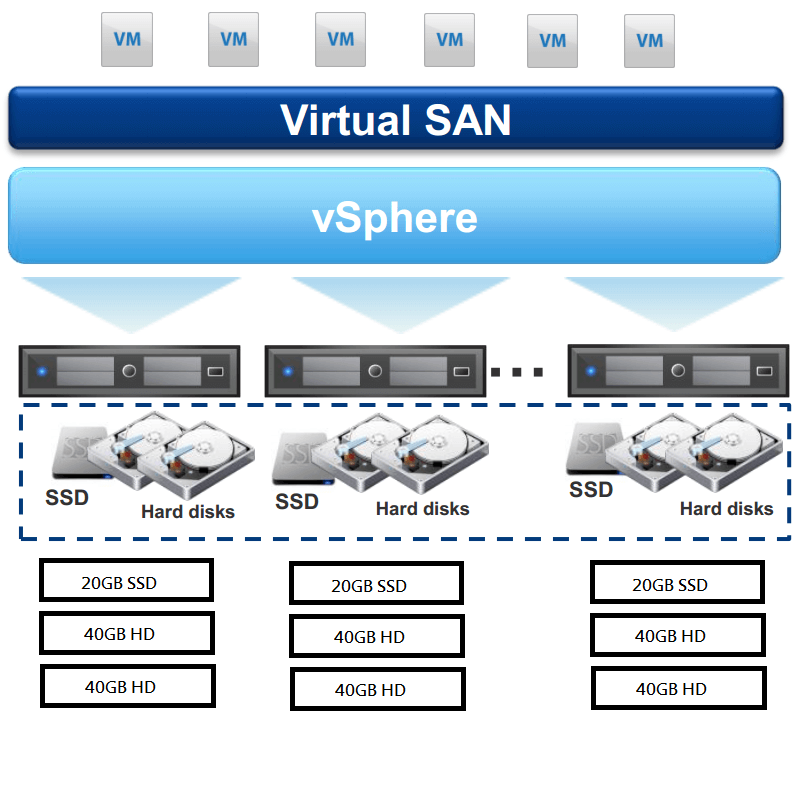

今までストレージで処理していた冗長性(RAID)部分を筐体間でRAIDを作るような仕組みです

ベンダー資料やメーカーの説明を聞く限り、パフォーマンスに問題がないということだが実際はどうなのだろうか。 気になったので試してみました

検証構成

今回は評価版で試せるvSANで実施しています 詳しい構成は省きますが、自宅サーバー組み換えのタイミングでやったのでこんな感じです

物理ホスト1

物理ホスト2

物理ホスト3 Withess用 適当なNUC

![ãã«ã©ã¼ããªã¨ã¼ã·ã§ã³ã DC3217IYE [Black] ã®è£½åç»å](http://img1.kakaku.k-img.com/images/productimage/fullscale/K0000443183_0002.jpg)

ディスク構成

ネットワーク設定はこんな感じ

10GbpsのNICがないのでとりあえずあるだけNIC突っ込んでNICチーミングで負荷分散できないかとこの構成にしました

結果と考察

vSAN上のWindows仮想マシンでCrystal Disk Infoを回した結果がこちら

Writeが遅い。。。。

なお画像は取り忘れましたが、同じ構成をSSDオンリーのローカルストレージで回したらWriteは500MB/sくらい出ていました。

ここから考察すると以下と考えられる

- vSANのReadは分散ディスクのうちどちらか一方からのみ応答を行っている

- Writeは整合性担保の関係で対向ストレージからの応答を待ってからWrite完了を返している

- NICの負荷分散は物理ホストが1対1である限り意味をなさない。おそらくチーミングやスイッチ側リンクアグリゲーションいずれを使っても、NIC振り分けがPortやIP,Macアドレスに縛られる限り分散はしない。

結論

vSAN用のNICは10G必須みたいです。

今回の検証前にKVMwith oVirt+Glusterfsも試してたのですがうまく構築できませんでした。環境構築がうまくいったら試してみようと思います